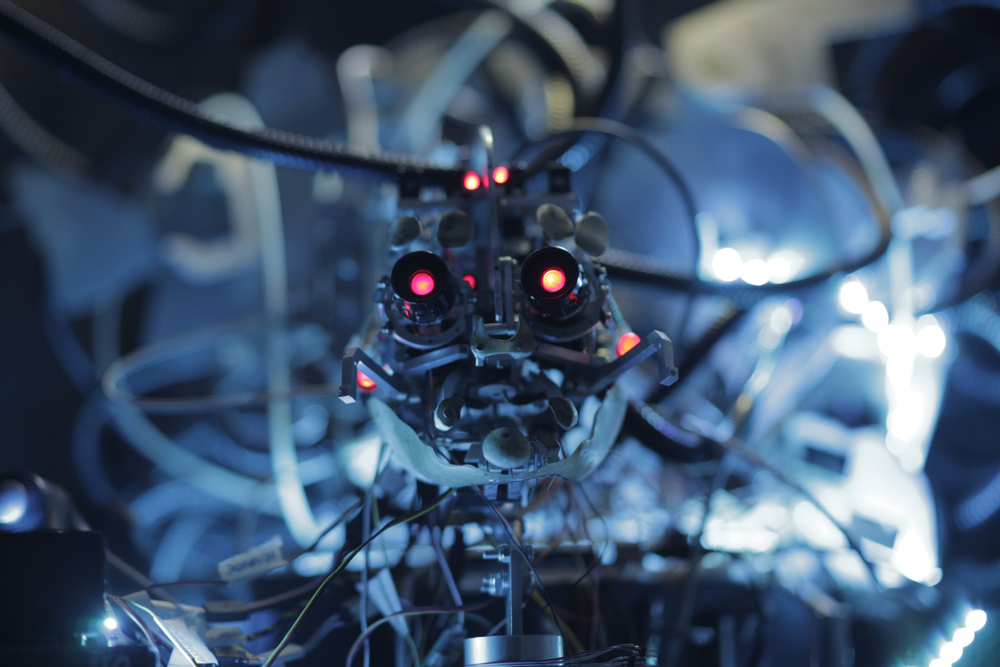

La guerre a toujours été un terrain d’expérimentation technologique. Mais avec l’arrivée de l’intelligence artificielle dans les systèmes d’armement, nous franchissons un seuil inédit : celui où la machine pourrait décider seule de la vie ou de la mort. Les robots tueurs, ou systèmes d’armes autonomes, ne sont plus un concept futuriste. Ils s’invitent dans les stratégies militaires, dans les budgets de défense, et surtout dans un débat éthique que le monde peine à affronter.

Les promoteurs de ces technologies avancent un argument séduisant : l’IA serait capable de réagir plus vite qu’un humain, de réduire les pertes militaires, d’améliorer la précision des frappes. Dans un contexte de rivalités géopolitiques, certains États estiment qu’il serait irresponsable de ne pas investir dans ces armes autonomes si leurs adversaires le font. La logique de la course à l’armement reprend ses droits, alimentée par la promesse d’une supériorité technologique.

Mais cette vision oublie l’essentiel : une machine ne comprend pas la guerre. Elle ne saisit ni les nuances, ni les dilemmes moraux, ni les conséquences humaines de ses décisions. Un algorithme peut identifier une cible, mais il ne peut pas évaluer l’intention, le contexte, la proportionnalité. Il ne peut pas assumer la responsabilité d’une erreur. Et pourtant, c’est à lui que certains voudraient confier le pouvoir d’agir sans contrôle humain direct.

Les risques sont multiples. Techniques d’abord : un capteur défaillant, un brouillage, un piratage, un biais dans les données d’entraînement peuvent transformer un système autonome en menace incontrôlable. Stratégiques ensuite : si les robots tueurs deviennent la norme, le seuil d’entrée dans un conflit pourrait s’abaisser, car les dirigeants n’auraient plus à craindre de pertes humaines parmi leurs soldats. Politiques enfin : la prolifération de ces technologies pourrait permettre à des groupes armés ou à des régimes autoritaires de disposer d’une puissance létale sans précédent.

Face à ces dangers, de nombreuses organisations internationales appellent à un traité interdisant ou encadrant strictement les systèmes d’armes létales autonomes. Mais les négociations avancent lentement, freinées par les intérêts stratégiques et économiques des grandes puissances. Pendant ce temps, la technologie progresse, les prototypes se multiplient, et la frontière entre assistance automatisée et autonomie totale s’efface.

La question n’est plus de savoir si l’IA peut être utilisée dans la guerre, mais jusqu’où nous sommes prêts à aller. Laisser une machine décider de la mort d’un être humain n’est pas une évolution naturelle de la technologie. C’est un choix de société. Un choix qui engage notre conception de la responsabilité, de la dignité humaine et du contrôle démocratique sur la force armée.

À l’heure de l’IA, la guerre change de visage. Reste à savoir si nous aurons le courage de fixer des limites avant qu’il ne soit trop tard.